参考消息网4月27日报道 英国《新科学家》周刊4月22日刊发题为《人工智能的这一时刻会对社会产生什么样的永久性改变?》的文章。全文摘编如下:

人工智能的这一时刻与以往任何时候都不一样。强大的基于语言的人工智能在性能上突飞猛进,现在可以生成大量逻辑通顺的论文,与人类撰写的论文难以区分。它们能够回答刁钻的技术问题。它们甚至可以帮助人类更好地训练其他人工智能。

然而,它们也引起严重关切。杰出的人工智能研究者和科技行业领袖呼吁相关实验室将正在进行的最大规模的人工智能实验至少暂停六个月,以便留出时间制定安全指导意见并付诸实施。

这一切的核心是大规模的语言模型和其他类型的生成式人工智能,它们可以根据人类的提示创建文本和图像。自2022年以来,由世界上最强大的科技公司支持的初创企业一直在加快这些生成式人工智能的部署——让广大用户能够用上答案看似可靠但往往不准确的聊天机器人,同时用人工智能生成的文字和图像充斥互联网,而这一切可以重塑社会。

新产品爆炸式增长

长期以来,人工智能研究一直伴随着炒作。但致力于突破界限的人和呼吁克制的人似乎在一个问题上达成一致:生成式人工智能可能比以前的人工智能产生更广泛的社会影响。

人工智能的故事是一个周而复始的故事,先是兴趣和资金激增,然后是巨大期待落空后的归于平静。上世纪50年代,人们热情地想要创造具有人类智能水平的机器。但这个宏大的目标并没有实现,计算机的硬件和软件很快遇到技术瓶颈。结果是,在上世纪七八十年代末出现了所谓“人工智能的冬天”,研究资金和企业兴趣全都烟消云散。

过去十年算得上是“人工智能的夏天”。由于算力大大增强,并且可以获得海量数据,一种受大脑启发的使用人工智能的方法取得了很大成功。

在过去几个月里,同样使用神经网络的生成式人工智能已成为科技行业的突破重点,各家公司争先恐后地将人工智能从实验室推向公众。当个人和组织试用这些模型时,其生成的结果是混乱的,而且往往不可预测。

加利福尼亚州分布式人工智能研究所创始人蒂姆尼特·加布鲁说:“我真的没想到我们现在看到的生成式模型会出现爆炸式增长。我从未见过产品如此迅速地激增。”

这场爆炸的导火索来自旧金山的开放人工智能公司(OpenAI),该公司于2022年11月30日推出了一款基于人工智能的聊天机器人ChatGPT的公共原型,在5天内吸引了100万用户。微软对OpenAI投资了上百亿美元,随后于今年2月在其必应搜索引擎上推出一款由ChatGPT相同技术驱动的聊天机器人,这显然是为了挑战谷歌在搜索引擎市场的长期主导地位。

这促使谷歌在3月推出自己的人工智能聊天机器人巴德。谷歌还向Anthropic公司投资3亿美元,这是一家由OpenAI前员工创立的人工智能初创公司,该公司从3月开始向少数用户和商业合作伙伴开放克劳德聊天机器人。百度和阿里巴巴等中国科技巨头也加入将人工智能聊天机器人纳入搜索引擎和其他服务的竞争。

真实风险飞速显现

这些生成式人工智能已影响到教育等领域,一些学校禁止使用ChatGPT,因为它可以生成整篇论文,无法确定是否由学生所写。软件开发人员已经证明,ChatGPT可以发现并修复代码中的错误,也可以从头开始编写某些程序。房地产经纪人使用ChatGPT生成新的报价表和社交媒体帖文,律师事务所也使用人工智能聊天机器人起草合同。美国政府的实验室甚至正在测试如何利用该技术快速筛选已发表的研究,以帮助指导新的科学实验。

投资银行高盛的分析师发布的一份报告显示,估计有3亿个全职工作岗位可能会被生成式人工智能至少部分取代。然而,这取决于“生成式人工智能是否实现其承诺的能力”。这是一个熟悉的警告,以前在人工智能的繁荣-萧条周期也出现过。

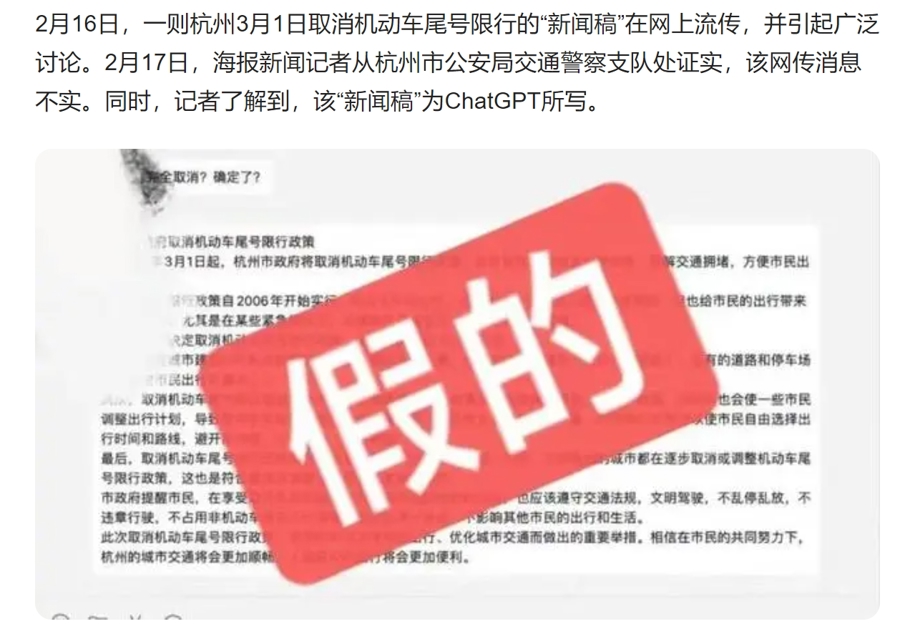

显而易见的是,生成式人工智能所构成的真实风险正在飞速显现。ChatGPT和其他聊天机器人经常出现事实错误,引用完全虚构的事件或文章,在案例中编造性骚扰丑闻、诬告真实的人等。ChatGPT的使用也导致了数据隐私丑闻,涉及公司机密数据的泄露。此外,ChatGPT用户还能够查看他人的聊天记录和个人支付信息。

艺术家和摄影师对人工智能生成的艺术品威胁到他们的生计更感到担忧,与此同时,一些公司在未经补偿的情况下,直接使用这些艺术家和摄影师的作品训练生成式人工智能。人工智能生成的图像也可能导致大规模的错误信息,美国前总统唐纳德·特朗普被捕和教皇方济各穿着时尚的白色羽绒服的虚假人工智能合成照片就证明了这一点。

加强监管日益紧迫

普林斯顿大学的阿尔温德·纳拉亚南说,生成式人工智能技术建立在十年的研究基础上,这些研究使人工智能在识别图像、根据主题对文章进行分类以及将口语转换为书面语方面的能力显著提高。通过逆向反转这一过程,生成式人工智能可以在给出描述时生成合成图像,生成命题论文,或者根据文本生成音频。纳拉亚南说:“人工智能真的让许多新事物成为可能。”但他也表示,这项技术可能很难评估。

大型科技公司发布的强大人工智能往往是封闭系统,限制公众或外部开发者的访问。封闭系统将权力集中在开发人工智能的组织手中,不允许可能被人工智能影响生活的普通大众提供任何意见。

这种趋势可以从OpenAI如何在技术上走向专有和封闭的立场中看出,尽管它最初是一个致力于人工智能开放开发的非营利组织。当OpenAI将ChatGPT的底层人工智能技术升级为GPT-4时,该公司以“GPT-4等大型模型的竞争格局和安全影响”作为不披露该模型如何工作的原因。

这种立场使外界很难评估生成式人工智能的能力和局限性,可能会助长炒作。弗吉尼亚理工大学科技史学家李·文塞尔说:“技术泡沫会产生很多情绪能量,既有兴奋也有恐惧,但它们是糟糕的信息环境。”

专家警告说,炒作和反对炒作的声音都会分散人们对于监管生成式人工智能的实际风险这一紧迫任务的注意力。

麻省理工学院经济学家达龙·阿杰姆奥卢说,GPT-4可以使许多任务自动化,大规模制造错误信息,锁定少数科技公司的主导地位,打破民主。他认为,目前是政府监管机构的“关键时刻”,应确保这些技术有助于劳动者并赋予公民权力,“对控制这项技术的科技巨头进行约束”。

欧盟立法者正在敲定一项人工智能法案,该法案将为监管这项技术制定世界上第一个广泛标准。这项立法旨在禁止高风险人工智能或对其进行监管,目前正在就是否将ChatGPT和具有通用用途的类似生成式人工智能纳入“高风险”类别进行辩论。与此同时,意大利监管部门暂时禁用ChatGPT,因为担心它可能违反现有的数据隐私法。

在这场生成式人工智能热潮中,接下来会发生什么,很大程度上取决于所涉及的技术如何得到使用和监管。阿杰姆奥卢说:“我认为历史上最重要的教训是,我们作为一个社会,在开放和应用技术方面有很多选择,而不是由技术梦想家告诉我们怎么选择。”