前特斯拉AI总监、现回归OpenAI的AI大神Andrej Karpathy在8月3日转发了一篇广为流传的博客文章。这篇文章探讨了英伟达GPU的短缺情况,认为小型和大型云供应商的大规模H100集群的容量正在耗尽;训练大型语言模型的初创企业、云服务供应商及其他大公司需要拥有超过1000张H100或A100,对大型开源模型进行重大微调的初创公司需要拥有超过100张H100或A100;预测H100短缺情况可能会持续到2024年。

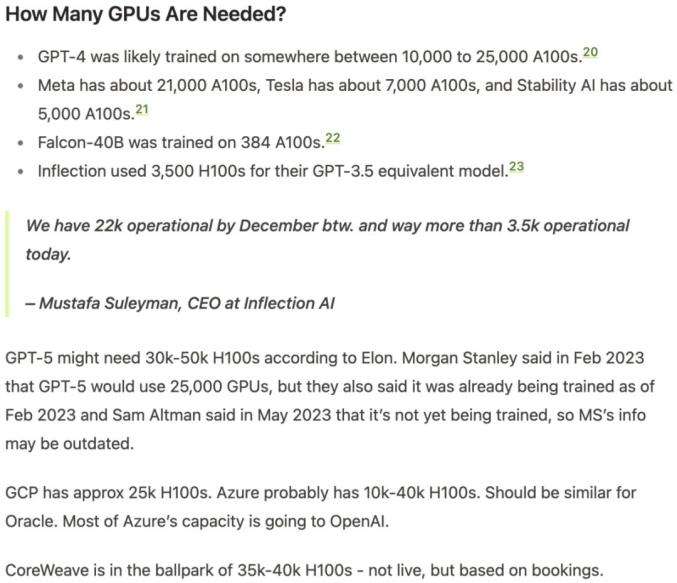

该文章预测GPT-4可能在10000到25000张A100上进行了训练,Meta拥有约21000张A100,特斯拉拥有约7000张A100,Stability AI拥有约5000张A100,Falcon-40B在384张A100上进行了训练。Inflection在其GPT-3.5等效模型中使用了3500张H100。GPT-5可能需要30000-50000张H100。GCP拥有大约25000张H100。微软Azure可能有10000-40000张H100,Oracle应该类似。CoreWeave预订的H100数量约为35000-40000张。

对H100的需求方面,OpenAI可能需要50000张,Inflection需要22000张,Meta可能是需要25000张(有人称实际上Meta想要10万张甚至更多)。大型云可能每个需要30000张(Azure、谷歌、AWS、Oracle)。Lambda和CoreWeave以及其他私有云可能总共需要10万张。Anthropic、Helsing、Mistral、Character,每家可能需要10000张。