据爱范儿援引SemiAnalysis报道,今天,OpenAI旗下的GPT-4大量模型架构、训练成本、数据集等大量信息被泄露。爆料人称,GPT-4架构的封闭性是因为他们构建的东西是可复制的,Google、Meta、Anthropic、Inflection、Character、腾讯、字节跳动、百度等在短期内都将拥有与GPT-4一样强大的模型。

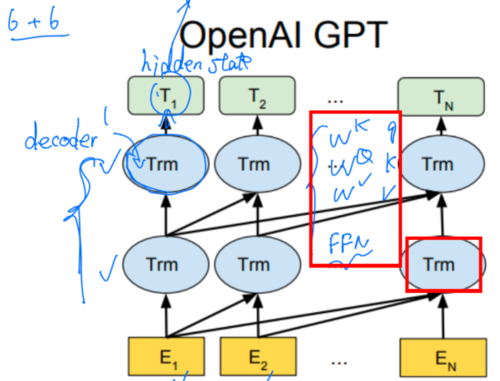

据透露,在模型架构方面,GPT-4的规模是GPT-3的10倍以上,作者认为GPT-4在120层中包含了1.8万亿参数,而GPT-3只有大约1750亿个参数。

OpenAI通过使用混合专家(MoE)模型来保持成本合理。具体而言,GPT-4拥有16个专家模型,每个专家的MLP参数约为1110亿。其中,有两个专家模型被用于前向传播。此外,大约550亿个参数用于注意力机制的共享。每次的前向传播推理(生成一个token)仅利用了约2800亿个参数和560TFLOP的计算。

在数据集构成方面,GPT-4的训练花费了13万亿的token数据集。这个数据集因为没有高质量的token,还包含了许多个epoch。

在并行策略方面,OpenAI采用了8路张量并行,因为NVLink最高只支持这么多。但除此之外,爆料作者听说OpenAI采用15路并行管线。

在训练成本方面,OpenAI训练GPT-4的FLOPS约为2.15e25,在大约25000个A100上训练了90到100天,利用率在32%到36%之间。

原文链接:

https://www.semianalysis.com/p/gpt-4-architecture-infrastructure