5月2日消息,大部分Ai机器人都是通过云端耗费大量的算力来完成的,即便是在自己的环境下,对硬件的需求也是非常高的。所以,有没有一种重量更轻,不需要网络连接的AI机器人?

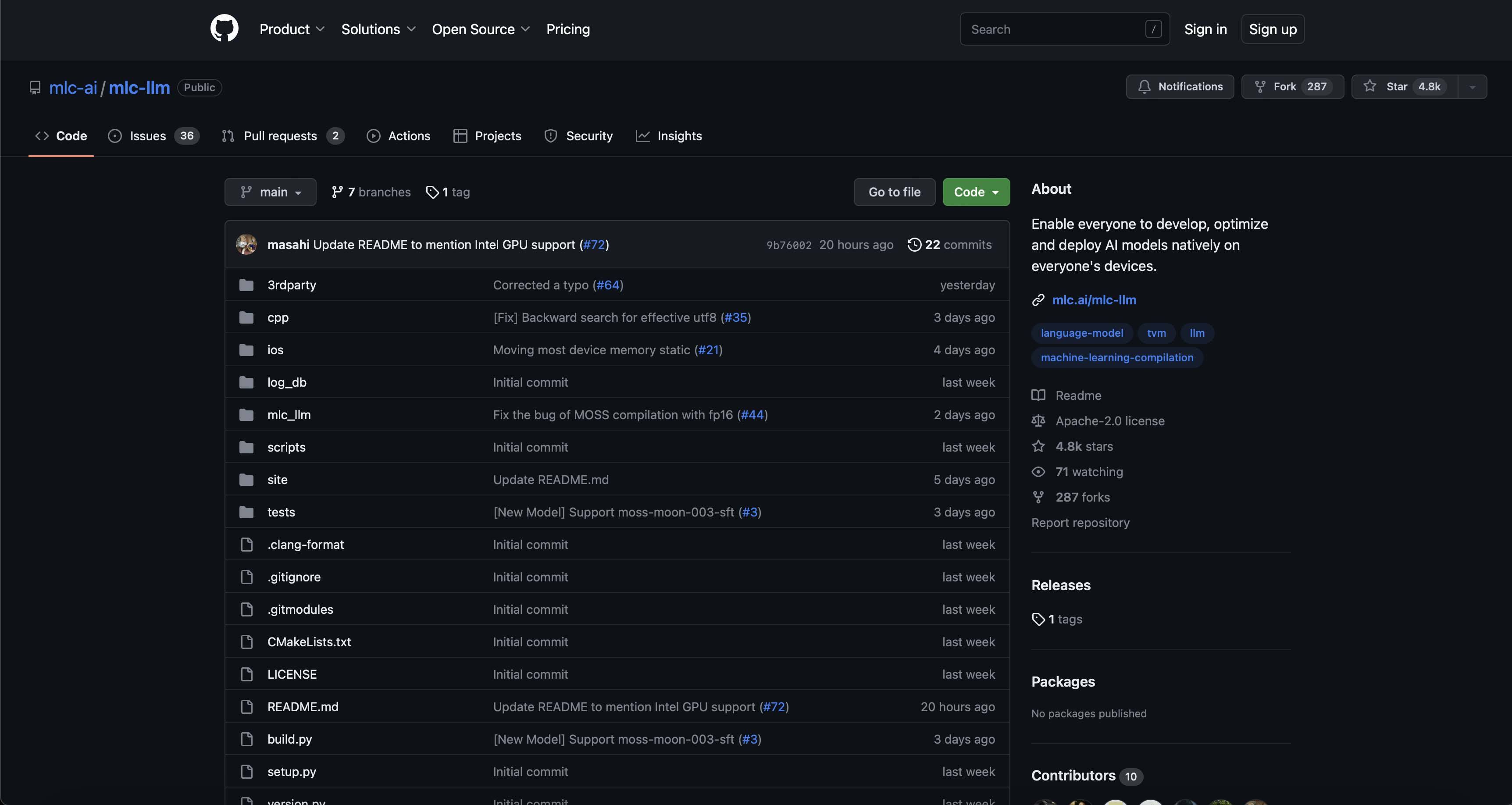

GitHub已经上线了一个名叫 MLCLLM的开源代码程序,该程序不需要网络就可以在本地工作,即使是旧电脑和苹果手机也可以使用。

MLC LLM计划简介:” MLCLLM是一个可以在各种硬件后端和原生软件上进行局部配置的普遍解决方案,同时也提供了一个有效的架构,可以让用户在各自的案例中对模型进行更多的优化。一切都是在当地进行,无需任何服务器支持,并且通过手机或笔记本的本地GPU来进行加速的。我们的任务是为所有人提供本地开发,优化,并在自己的装置上部署AI模型。”

▲ MLCLLM计划的正式展示

在 GitHub网页中显示,该软件的开发团队由卡内基梅隆大学(Catalyst)、美国 SAMPL (Sample)、美国华盛顿大学(Washington University)、上海交通大学(Time Washington University)、 OctoML (OctoML)组成。另外,他们也有一个与之相关项目,叫做 web LLM,这个项目可以让人工智能在网页上全部运行。

▲ MLC是机器学习交流的缩写

MLC LLM采用的是一种以元为基础的 LLaMA为基础的轻型 LLMVicuna-7B-V1.1,尽管它在尺寸上没有 GPT3.5和GPT4那么好。

现在, MLCLLM在 windows, linux, macOS, iOS上都可以使用。

据国外媒体 tomshardware称,6 G存储的 Apple iPhone 14 Pro Max和Iphone12 Pro Max已经在3 G上运行了 MLCLLM。4 G的iphone11不能支持 MLCLLM。

▲图片来源 Tomshardware

同时,第六代 Thinkpad X1C也在对 MLCLLM进行了测试,该电脑采用了i7-8550U,没有单独的视频卡,并使用了英特尔的UHS 620 GPU。MLC LLM是 PC端的,只能用命令行来操作,国外媒体的实验显示,它的性能很一般,回答问题的速度也很慢,只有30秒左右,没有任何的连贯性,我也不知道下个版本会不会有什么变化。

▲图片来源 Tomshardware

MLC LLM 的 GitHub 页面:点此查看