ChatGPT的开发机构OpenAI正在构建一个工具,可以对由其人工智能服务Dall·E 3创建的图像进行高度精确的检测。

当地时间10月17日,OpenAI首席技术官米拉·穆拉蒂(Mira Murati)在美国加利福尼亚州拉古纳海滩举行的《华尔街日报》Tech Live会议上透露了这一消息。她说,OpenAI的这个工具“99%可靠”,正在计划公开发布前进行内部测试,但她没有具体说明时间表。

OpenAI在今年1月发布了一个类似的工具,旨在确定文本是否是人工智能生成的,但该工具在7月被搁置,因为它并不可靠。该公司当时表示,正在努力改进软件,并致力于开发方法来识别音频或图像是否也是由人工智能生成的。

OpenAI开发的Dall·E是目前最强大的人工智能生成图像产品之一,与Midjourney和Stable Diffusion等软件共同为互联网提供了大量AI图像。其中一些虚假图片在社交网络上泛滥,特别是在重大国际冲突发生后。

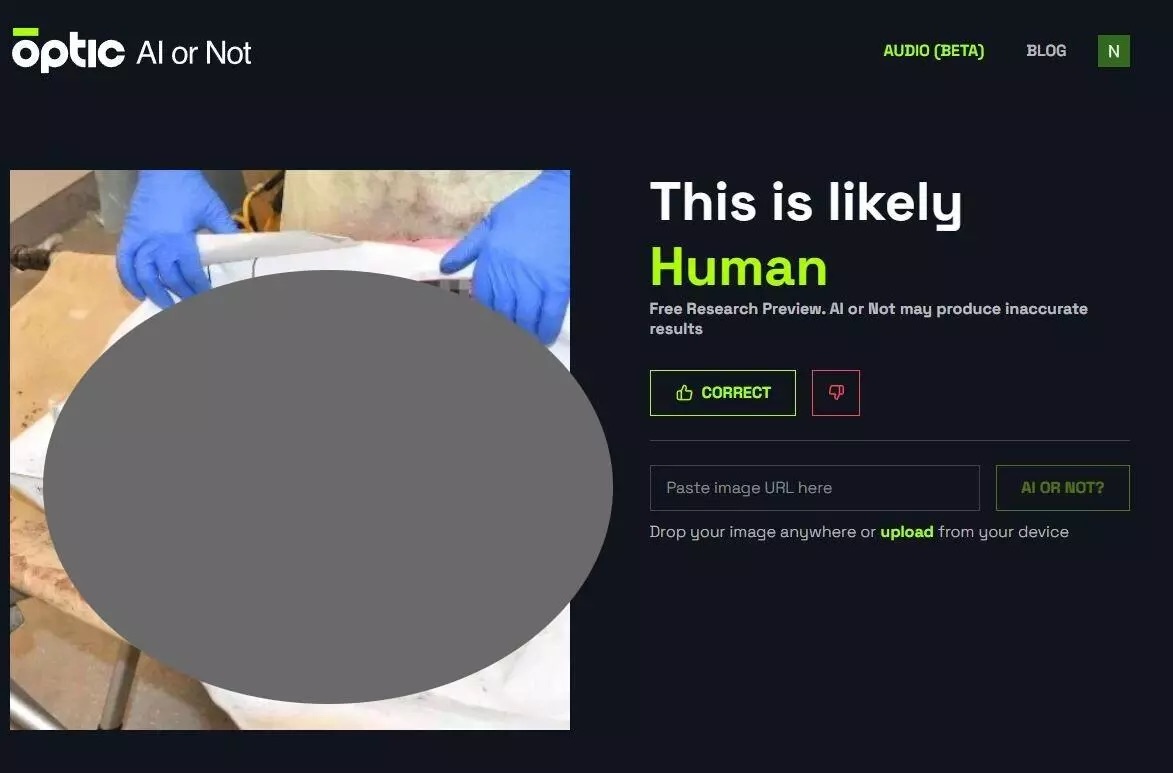

就在最近,一张关于以色列死婴的照片再次引发争议。10月12日,以色列总理本杰明·内塔尼亚胡的官方账户发布了一张被烧焦的尸体的图片,称该图片显示一名婴儿在10月7日的袭击中被极端组织哈马斯杀害。在图片发布后的几个小时内,许多社交媒体账号表示,基于名为“AI or Not”的人工智能检测工具的结果,这张照片是由人工智能生成的。然而,几位图像分析专家以及AI or Not背后的公司表示,这些结果是检测工具误报,这张照片很可能是真实的。

AI or Not最终检测结果显示,这张以色列死婴照片很可能是真实的。

在10月14日的一条推文中,AI or Not背后的公司表示,其软件能够误报,意味着它可以错误地得出真实照片是由人工智能生成的结论,尤其是当相关图像质量较低时。

专门从事图像分析的调查机构Bellingcat早在2023年9月就测试了AI or Not。“在识别被压缩的人工智能图像(尤其是真实感图像)时,AI or Not的错误率都很高,这大大降低了它对开源研究人员的实用性。”该团队总结。

自ChatGPT发布以来,已经有多个工具声称可以检测人工智能制作的图像或其他内容,但它们往往都不能保证完全准确。随着人工智能工具可用于操纵或捏造全球事件的新闻报道,对此类检测工具的需求只会越来越强。

17日,穆拉蒂还对GPT-4的后续AI模型作出了暗示。尽管OpenAI尚未公开表示GPT-4的后续模型可能会被称为什么,但该公司7月向美国专利商标局提交了“GPT-5”商标申请。当被问及GPT-5模型是否会不再散布谎言时,穆拉蒂说:“也许吧。”